Von der Signallampe zur Augmented Reality

Human Centered Automation

von Christoph Legat und Benno Lüdicke

Eines der Ziele von Industrie 4.0 ist die Optimierung der Zusammenarbeit zwischen Menschen und Maschinen – Stichwort Human Centered Automation. Dabei ist es ein zentrales Anliegen, die Fehlerquellen für den Menschen zu reduzieren. Viele Projekte befassen sich deshalb mit Assistenzfunktionen. Die Auswahl der Visualisierungsform ist dabei wichtig.

Egal, ob es im einzelnen Fall an der Kosteneffizienz oder an der Komplexität liegt: Automatisierung hat ihre Grenzen und zahlreiche Aufgaben in Produktion und Logistik werden auch weiterhin besser von Menschen erledigt. Andererseits weist Automatisierung im Vergleich zu menschlicher Tätigkeit meist deutlich geringere Fehlerquoten auf. Diesen Vorteil will man nutzen.

Der Weg dorthin sind Assistenzsysteme. Man kann bei Assistenzsystemen zwei grundlegende Basisfunktionen unterscheiden: Anleitung und Fehlerüberwachung. Während die Anleitung den Mitarbeiter darauf hinweist, wie er eine Aufgabe erledigen soll, und daher Fehler von vornherein zu vermeiden hilft, dient die Fehlerüberwachung dazu, potenzielle Fehler frühzeitig und rechtzeitig zu identifizieren, bevor sich negative Konsequenzen zeigen. In beiden Fällen ist eine visuelle Unterstützung für den Mitarbeiter von Vorteil.

In diesem Zusammenhang gewinnen Konzepte in der Industrie an Bedeutung, die bereits in den 1990er Jahren als technische Vision durch Mark Weiser formuliert wurden: ubiquitäre Systeme, die ihr Verhalten dem Menschen in Abhängigkeit des jeweiligen Kontextes anpassen. Unter Kontext wird in diesem Zusammenhang jede Information verstanden, die genutzt werden kann, um die Situation einer Entität zu charakterisieren.

Durch die zunehmende Digitalisierung und Vernetzung werden ubiquitäre Systeme für die Integration von Mensch und Maschine immer wichtiger. Gerade für Assistenzfunktionen sind der aktuelle Kontext und intelligente, kontextabhängige Benutzerschnittstellen sehr bedeutsam. Grundlage für Assistenzfunktionen ist eine geeignete Visualisierung, um die nötigen Informationen an den Benutzer weiterzugeben.

Die Mensch-Maschine-Schnittstelle

Wie soll eine Assistenzfunktion visualisiert werden? Für die Visualisierung gibt es viele Möglichkeiten mit unterschiedlichen Eigenschaften. Aufwand und technischer Reifegrad der Lösungen können sehr verschieden sein. Entscheidend für eine Assistenzfunktion ist es, Informationen genau dann innerhalb des Sichtfelds eines Mitarbeiters anzuzeigen, wenn er sie braucht.

Das Sichtfeld hängt dabei von der Tätigkeit ab: Beim Greifen oder Positionieren von Werkstücken hat der Mitarbeiter seine Hände in einem stabilen Sichtfeld. Bei Tätigkeiten wie der Steuerung eines Gabelstaplers verändert sich das Sichtfeld ständig, sodass die Hände meist außerhalb sind.

Diese beiden Beispiele zeigen zwei weitere wichtige Entscheidungsfaktoren: Während für die Navigationsfunktion eines Gabelstaplers eine stetige Assistenz nötig ist, erfordert die Warenaufnahme nur eine zeitlich beschränkte Assistenzfunktion. Neben dem Sichtfeld ist daher auch der Zeitpunkt einer Anzeige von hilfreichen Informationen zu bedenken.

Ein weiteres Auswahlkriterium für die Visualisierung einer Assistenzfunktion ist der Einfluss von Veränderungen des Sichtfelds auf die Effizienz. Diese kann durch verschiedene Zielgrößen definiert werden. Wenn man beispielsweise einen optimalen Durchsatz als Zielgröße sieht, sollte der Zeitgewinn durch eine Assistenzfunktion bei der Verarbeitung eines Werkstücks oder Produkts größer sein als der Zeitverlust durch den Blick auf ein Visualisierungsgerät. Neben der Fehlerquote wäre auch Flexibilität eine mögliche Zielgröße – hier spielen zeitliche Unterbrechungen für den Informationsgewinn dann eine untergeordnete Rolle.

Anzeige immer im Blick

Ist das Sichtfeld durch die Position des Mitarbeiters einigermaßen fest definiert, bieten sich stationäre Visualisierungssysteme an. Die Vielfalt technischer Lösungen ist dabei groß und reicht von einfachen Signalgebern wie etwa Signalampeln oder Signallampen bis hin zu Displays, Eingabe-Panels oder Bildprojektionen für die komplexe Visualisierung.

Anwendungsspezifische Signalgeber sind einfach und kostengünstig zu installieren, aber unflexibel und lassen sich leicht fehlinterpretieren. Visualisierungsgeräte wie Displays oder Projektoren können eine große Menge komplexer Informationen unterschiedlich darstellen. Die Informationen lassen sich zudem nachträglich anpassen oder erweitern. Auch Informationen, deren Semantik nicht vollständig bekannt ist oder die nicht unbedingt interpretiert werden müssen, lassen sich damit anzeigen: Während die Bedeutung einer einzelnen blinkenden Signallampe dem Bediener a priori bekannt sein muss, ist die entsprechende Information in grafischen Displays direkt darstellbar. Der technische Reifegrad solcher Systeme ist sehr hoch; robuste Geräte in unterschiedlichen Schutzklassen sind erhältlich.

Ob und wie sich stationäre Visualisierungssysteme installieren lassen, hängt besonders von den Aufgaben des Mitarbeiters (und dem Sichtfeld, das sich dadurch ergibt) sowie dem Arbeitsumfeld ab. Zu beachten ist hier auch, dass bei Tätigkeiten, in denen das Auge die Bewegung verfolgt, Körperteile das Sichtfeld beeinflussen und Visualisierungen überdecken können.

Mobile Geräte

Ist der Mitarbeiter in Bewegung, sind Mobile Devices eine Alternative zu stationären Installationen. Die im privaten Alltag omnipräsenten Smartphones und Tablets dringen auch in industrielle Anwendungen vor. Dort stehen sie ständig für eine Visualisierung bereit, sodass der Zeitpunkt visueller Assistenz nicht von vornherein bestimmt werden muss und nachträglich angepasst werden kann.

Weil immer bessere mobile Rechenleistung und Kameratechnik für immer weniger Geld zu haben sind, werden zunehmend Assistenzfunktionen auf Basis von Augmented-Reality-Techniken entwickelt. Dabei werden Kamerabilder (meist aktuelle Videobilder) durch zusätzliche Informationen erweitert, die an geeigneter Stelle ins Bild eingeblendet werden. Für die mobile Visualisierung gibt es hauptsächlich drei Geräteklassen: Tablets und Smartphones, am Körper getragene Geräte und Datenbrillen.

Tablets und Smartphones

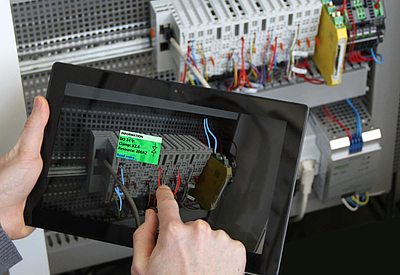

Tablets und Smartphones zeigen einen hohen technischen Reifegrad, sodass Investitionssicherheit für Industrieanwendungen gegeben ist. Vom privaten Handy her bekannte Bedienkonzepte können genutzt werden, was den Schulungsaufwand bei der Einführung einer Applikation senkt. So ermöglichen die Geräte, sofern sie eine Kamera eingebaut haben, auch Augmented-Reality-Anwendungen (siehe Abbildung 1).

Zu berücksichtigen ist dabei, dass der Benutzer das Mobile Device in die Hand nehmen muss, um es in das Sichtfeld zu bewegen. Besonders in Augmented-Reality-Anwendungen wird die Information am besten dargestellt, wenn das Gerät mit mindestens einer Hand auf entsprechende Positionen/Richtungen ausgerichtet wird.

Am Körper getragene Geräte

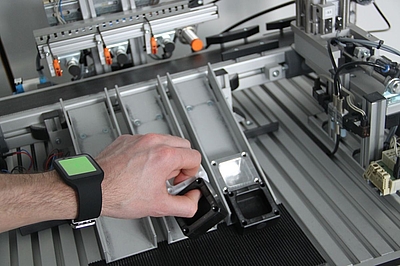

Während Smartwatches (siehe Abbildung 2) beim Konsumenten nicht im Entferntesten an den Erfolg von Smartphones anschließen konnten, sind sie als tragbarer Embedded-PC mit Display nicht uninteressant für Visualisierungslösungen. Der technische Reifegrad der Geräte ist hoch, im Einsatz zeigen sie jedoch noch Schwächen. So müssen sie in der Industrie zusätzliche Anforderungen an die Robustheit erfüllen.

Für Assistenzfunktionen ist die mögliche Nutzungsdauer ohne Aufladen des Akkus oft zu kurz, weil die Funktionen in der Industrie wesentlich intensiver genutzt werden als im Privaten. Dem lässt sich jedoch beispielsweise durch verbesserte Akkus oder, je nach Anwendung, durch die doppelte Anzahl von Geräten und geeignete Wechselstrategien für die Belegschaft abhelfen.

Weil Displays von Smartwatches recht klein sind, kann nur wenig Information visualisiert werden. Ferner befindet sich eine Uhr nicht immer im Sichtfeld des Benutzers. Die Folge ist, dass sich sinnvolle Assistenzfunktionen auf kurze Rückmeldungen zur momentanen Tätigkeit beschränken; detailliertere Informationen lassen sich dann übermitteln, wenn die aktuelle Aktivität geringe Aufmerksamkeit erfordert oder zwischenzeitlich kurz unterbrochen wird. Analog zu Smartwatches gibt es ähnliche Konzepte mit identischer Charakteristik, etwa Armmanschetten mit integriertem PDA, auf den Arm projizierte Informationen oder Arbeitshandschuhe mit entsprechend integrierter Rückmeldungsfunktion. Der technische Reifegrad dieser Anwendungen schwankt dabei stark.

Datenbrille

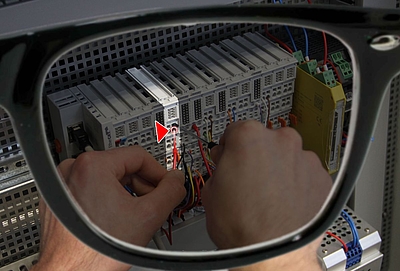

Ein Smartphone oder Tablet muss man in die Hand nehmen, wodurch zusätzliche Aktivitäten eingeschränkt sind; Freihandvisualisierungsformen sind daher für Assistenzsysteme besonders interessant. Eine Freihandvisualisierung, die sich stets im Sichtfeld des Mitarbeiters befindet, lässt sich mittels sogenannter Head-Mounted Displays realisieren. Der wohl bekannteste Vertreter dieses Gerätetyps sind Smart Glasses, also Brillen mit eingebauter Visualisierung (siehe Abbildung 3). Assistenzfunktionen auf Basis dieser auch als Datenbrillen bezeichneten Geräte nutzen meist Augmented-Reality-Techniken, um Informationen korrekt verortet anzuzeigen – mit Bezug auf physikalische Objekte, die sich gerade im Sichtfeld befinden.

Datenbrillen zeigen bereits einen mittleren technischen Reifegrad. Es gibt auch schon robuste Modelle für den Einsatz in der Industrie. Momentan werden Datenbrillen für Assistenzaufgaben in diversen Industriezweigen getestet. Untersuchungen zeigen, dass Smart Glasses mit ihren Visualisierungs- und Assistenzfunktionen die Fehlerquote, aber auch die Arbeitsgeschwindigkeit verringern können. Eine generalisierte Aussage darüber ist jedoch momentan noch nicht möglich. Brillenträger tun sich mit Smart Glasses noch schwer; geeignete Lösungen werden derzeit entwickelt.

Kriterien zur Auswahl

Die Wahl der Visualisierungslösung hat eine Reihe von Implikationen: Je nach gewählter Technik sind die Assistenzfunktionen mehr oder weniger flexibel. Während spezifische, einfache Installationen für genau eine Assistenzfunktion kostengünstig und technisch robust zu realisieren sind (wie einfache Signalampeln), lassen sich Assistenzsysteme, die sich stets innerhalb des mobilen Sichtfelds eines Mitarbeiters befinden, derzeit nur mit Visualisierungskonzepten wie etwa Smart Glasses umsetzen. Solche Geräte sind jedoch technisch noch nicht so ausgereift wie stationäre oder mobile Industriedisplays.

Viele Projekte zur Einführung von Assistenzfunktionen leiden deshalb unter einem Dilemma: Einerseits sind kostengünstige und zugleich effektive Lösungen erwünscht, andererseits bleibt dadurch Potenzial ungenutzt, was sich auf die Wettbewerbsfähigkeit des Unternehmens auswirken kann. Auf dem Weg zur Industrie 4.0 empfiehlt sich daher ein dualer Ansatz: Einerseits sollte man mittels kostengünstiger, technisch ausgereifter Lösungen kurzfristig das Fehlerpotenzial gezielt an bestimmten Stellen reduzieren. Andererseits kann man dann parallel dazu eine langfristig angelegte, an unternehmensspezifische Bedürfnisse und Randbedingungen angepasste, ganzheitliche Lösung entwickeln.

Kontextsensitive Benutzerschnittstellen und Assistenzfunktionen sind nicht nur eine Frage technischer Lösungen zur Visualisierung. Bei der Umsetzung erweist sich vielmehr die Bestimmung des Benutzerkontexts oft als große Herausforderung. Die Gründe dafür sind vielfältig. So sehen Arbeitsorganisationen auf dem Weg zur Industrie 4.0 vor, dass ein einzelner Mitarbeiter unterschiedliche Aufgaben ausführt. Für optimale Assistenzfunktionen müssen folglich die Aufgabe und die Rolle des Benutzers eindeutig bestimmt werden. Hierzu sind häufig Informationen aus vielen verschiedenen Teilsystemen nötig, sodass heterogene Daten integriert und aggregiert werden müssen.

Wenn mobile Visualisierungssysteme zum Einsatz kommen, ist der aktuelle Ort eine weitere wichtige Kontextinformation. Während es für die Lokalisierung im Freien viele technisch ausgereifte Ansätze gibt, etwa mittels GPS, ist die Lokalisierung eines Benutzers im Gebäude (und besonders in der Werkshalle) momentan eine technische Herausforderung.

Ausblick

Die Assistenz mittels eines der beschriebenen Medien resultiert auch in weiterführende Herausforderungen außerhalb der technischen Perspektive. Beispiel: Wer zeigt sich verantwortlich, wenn Schäden wegen falscher Anweisungen eines Assistenzsystems entstehen? Es ist daher unumgänglich, solche Projekte in interdisziplinären Teams durchzuführen.

Insgesamt eröffnen Digitalisierung und Vernetzung Chancen, bisher ungenutztes Potenzial zu heben. Die Einführung neuer Assistenzfunktionen erweist sich in der Praxis jedoch als komplexe, multidisziplinäre Herausforderung, die eine ganzheitliche Betrachtung und (zumindest mittelfristig) eine strategische Berücksichtigung erfordert.

Die Wahl der Visualisierungsmethode ist ein wichtiger Teilaspekt – allerdings einer, der leichter werden wird. Man kann davon ausgehen, dass die rasante Entwicklung neuer mobiler Devices auch immer mehr Produkte hervorbringen wird, die sich zur Verbesserung des Zusammenwirkens von Mensch und Technik im industriellen Umfeld eignen werden.

Christoph Legat